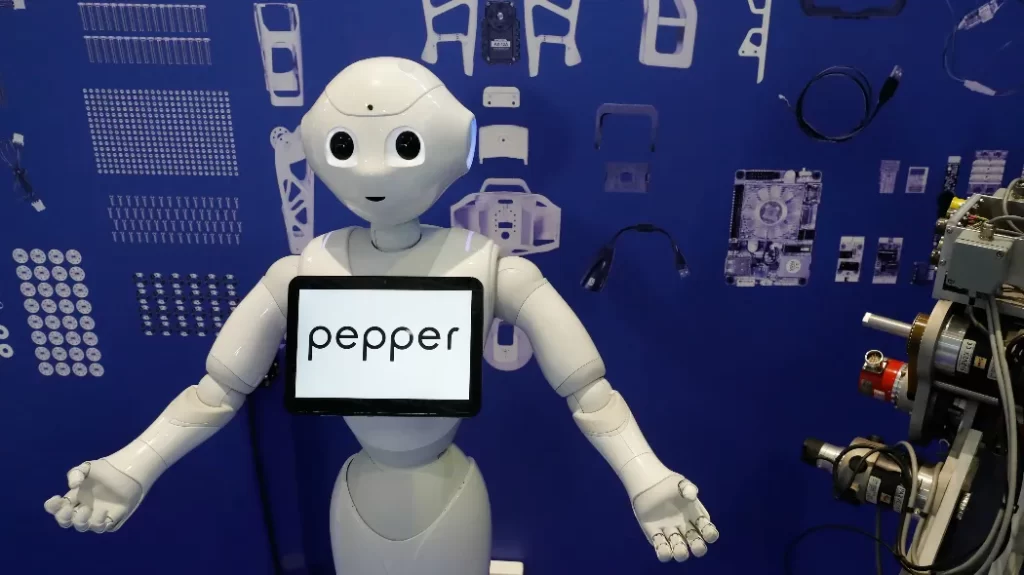

Pepper segue la voce del suo interlocutore, gira il viso, sposta il corpo. Ha microfoni e telecamere, risponde alle domande e riflette ad alta voce. Ma non è tutto: infatti, oltre ai comportamenti base presenti negli altri robot della stessa categoria, Pepper ha una vita interiore, reagisce agli stimoli e spiega i sentimenti e le emozioni che sta provando.

Siamo di fronte all’ultima innovazione dell’intelligenza artificiale, che d’ora in avanti sarà ancora più futuristica e facile da comprendere. Si tratta di un automa in grado di parlare e persino di spie- gare il processo decisionale che l’ha spinto a realizzare le attività. Una novità importante e curiosa che ha attirato le attenzioni degli esperti di AI in tutto il mondo. Questo robot è stato programmato dal team guidato dalla professoressa Arianna Pipitone nel laboratorio di robotica fondato nel 1997 dal professor Antonio Chella nel Dipartimento di Ingegneria dell’università di Palermo, un centro all’avanguardia nella robotica cognitiva, che sviluppa macchine sempre più simili alle persone.

Pepper è un umanoide dal viso simpatico e rassicurante, con grandi occhi tondi e alto come un bambino di cinque anni. Il suo aspetto non è affatto un elemento secondario, proprio come ha spiegato ai microfoni di Sky tg24 il professor Antonio Chella: «Il nostro principale interesse è sempre stato quello dell’interazione con le persone. La nostra mission è la robotica sociale. Da sempre sogniamo un mondo in cui umani e robot possano convivere insieme e con il giusto livello di fiducia.

Questo perché gli esseri umani devono imparare a fidarsi dei robot nella maniera più corretta approfittando delle straordinarie possibilità che essi offrono».

Il gruppo di ricerca della facoltà di Ingegneria dell’università di Palermo collabora con filosofi, musicisti, psicologi e neuro-scienziati e con loro studia le persone per poter individuare modelli computazionali da inserire nei robot. Il team lavora, dunque, sulle emozioni e sulla teoria della mente, con l’obiettivo di realizzare robot sempre più avanzati ed empatici, capaci di capire con chi stanno dialogando e di interagire in maniera corretta con gli esseri umani.

Dunque, per esplorare come la presenza di un linguaggio interiore può influire sulle azioni di un robot, i ricercatori italiani hanno costruito un modello cognitivo speciale che rende i robot in grado di parlare con sé stessi. Gli studiosi hanno poi aggiunto questo sistema in un robot Pepper – prodotto dal colosso giapponese Softbank – e già disponibile in commercio.

Attraverso la voce, l’utente può tracciare i pensieri del robot con intelligenza artificiale e apprendere che Pepper è in grado di affrontare un dubbio e risolverlo dando priorità alla richiesta umana.

Grazie alle sue abilità, Pepper ha superato i requisiti funzionali e gli standard internazionali per la categoria dei robot collaborativi: infatti viene usato in alcuni ospedali e strutture mediche come assistente. L’aggiunta della capacità di “pensare” lo rende ancora più innovativo.